AI har for alvor gjort sit indtog med fremkomsten af Chat GPT og det kapløb blandt tech-giganterne, som er er fulgt i kølvandet. I dag kan vi ved hjælp af AI generere resultater med billeder og ord, hvor det ikke er muligt at vide, at de er skabt uden menneskelig indblanding. Også på det juridiske område er potentialet revolutionerende, og det er meget sandsynligt, at voldgiftsområdet kan blive et af de første steder, hvor vi ser et egentligt gennembrud. Men har vi egentlig på det punkt forstået, hvad det er vi er i færd med, og hvilken målestok vi skal anvende i forhold til at bedømme output genereret af AI, spørger advokat og partner Niels Chr. Ellegaard, Plesner, i denne analyse.

Af advokat og partner Niels Chr. Ellegaard, Plesner Advokatpartnerselskab

Voldgiftsafgørelser beror på juridisk beslutningstagning, og vi har aldrig sat spørgsmålstegn ved den menneskelige beslutningsproces – i al fald ikke så længe der har været tillid til institutionerne. Men hvad gør vi, hvis de juridiske beslutninger helt eller delvist overlades til robotter? Hvilken målestok skal definere, om de gør det forsvarligt, korrekt og tilstrækkelig godt? Og er vi nødsaget til at gentænke rammerne for selve det at træffe en juridisk beslutning? Har vi her chancen for at gøre det bedre end den menneskedrevne juridiske beslutningstagning?

De juridiske positioner som omdrejningspunkt

Al jura handler i sidste instans om at tilvejebringe juridiske positioner, som skal munde ud i konkrete handlinger eller undladelser. På det erhvervsjuridiske område typisk i form af transaktionelle relationer, mellem købere og sælgere, hvor varer, tjenesteydelser eller arbejdskraft udveksles mod penge.

Laver du lovgivning eller kontrakter – her samlet betegnet som “regulering” – inden for dette felt er det i sidste ende med henblik på at skabe grundlaget for disse transaktioner (i form af juridiske positioner) og normalt altid fremadrettet. Rådgiver du som advokat er det normalt enten fremadrettet – altså hvad må positionerne i en fremtidig transaktion forventes at være i en bestemt relation og kan de tydeliggøres? Eller bagudrettet: Hvad var de ved lov givne eller aftalte positioner rent faktisk?

Juridiske beslutningstagning (legal decision making) er baseret på den juridiske metode, og er den proces, vi anvender til at fastlægge de juridiske positioner: (i) Hvilke juridiske positioner (der kan omsættes til handlinger/undladelser i virkelighedens verden) følger af (ii) reguleringen og supplerende retskilder (samlet betegnet “jus”) på grundlag af (iii) et givet sæt af fakta?

Alt dette er i og for sig banalt – bortset fra, at vi som jurister aldrig rigtig har keret os om, hvordan vi kommer fra A til B. Hvordan er det lige, vi når fra fakta + jus til de juridiske positioner? Vi har stiltiende lagt til grund, at hver enkelt må gøre det på sin egen måde, så længe resultatet kan forsvares inden for rammerne af den juridiske metode. Med andre ord er den juridiske beslutningstagning et privat anliggende, hvilket vi har levet fint med siden “arilds tid”.

AI’s indtog i voldgift

Lige p.t. er vi ikke der, hvor robotter kan overtage en voldgiftsrets arbejde med juridisk beslutningstagning og fastlæggelse af juridiske positioner i konkrete sager til afgørelse. Der er imidlertid intet til hinder for, at den eksisterende generation af generativ AI – det vil sige robotter, der skaber eller genererer nyt indhold baseret på eksisterende data – kan udvikles til at bistå en voldgiftsret med at træffe afgørelse og fastlægge de juridiske positioner.

En voldgiftsdommer kan således prompte en chatbot og få et resultat, der kan kopieres ind i en kendelse. Kvaliteten af output fra de chatbots, der er på markedet lige nu er ikke god nok, og der er også i eksempelvis ChatGPT indsat såkaldte “guardrails” i forhold til at forhindre robotten i at assistere med denne opgave. Disse guardrails kan dog forholdsvist nemt omgås.

Potentialet for anvendelse af AI i voldgift er ikke større end ved domstolene. Når det alligevel må forventes, at voldgiftsområdet kan blive et af de første, der for alvor kommer til at bruge AI til juridisk beslutningstagning skyldes det, at

- Rammerne er mere frie og i højere grad tillader eksperimenter

- Parterne har en høj grad af aftalefrihed

- Parter der bruger voldgift har normalt et stærkt ønske om en hurtig og effektiv proces og vil gerne fremme dette yderligere

- AI kan bringe omkostningerne ned

Samtidig er voldgift konkurrenceudsat, og det er tænkeligt, at sagerne vil søge derhen, hvor de kan løses bedst, hurtigst og billigst.

Disse faktorer kan skabe en bevægelse mod anvendelse af AI i voldgifter – og formentlig først og fremmest de institutionaliserede af slagsen, da parterne i en tvist må formodes at have et ønske om ikke at blive “ad hoc prøvekaniner”.

Vejen frem mod dette vil være brolagt med praktiske forhindringer: (i) Hvem vil lægge sager til at få trænet robotten og kvalitetssikret dens deltagelse, (ii) er der i det hele taget kritisk masse til at få trænet robotten tilstrækkeligt inden for en rimelig tidshorisont (iii) Sagerne er fortrolige – det kan derfor blive vanskeligt at få lov at træne robotten, medmindre det sker i et afgrænset sandbox-miljø, (iv) Hvem skal stå for træningen (de enkelte voldgiftsdommere udpeges jo typisk for en sag ad gangen og har i de fleste tilfælde ikke indsigten og erfaringen til at træne robotten).

Man kunne forestille sig, at man som en del af en voldgiftsinstitution nedsatte en task force, der samarbejdede og assisterede den enkelte voldgiftsret med henblik på at få trænet og anvendt robotten bedst muligt. Robotten kunne starte med lidt lettere opgaver i form af, at den måske kunne sammenfatte fakta i sagsfremstillinger og lave resumeer af dokumenter mv. for derefter at lade den tage stilling til delspørgsmål og ultimativt til sidst hele sagen.

Men så snart robotten kan levere et nogenlunde troværdigt output som led i træning opstår spørgsmålet: Skal det så bruges i den konkrete afgørelse og på hvilke betingelser kan det så ske?

De fundamentale spørgsmål vedrører slet ikke teknologien – de drejer sig om os selv

Og her melder den centrale problemstilling sig. Mange har øje for problemet i, at de algoritmer, der indgår i AI indebærer en “black box” udfordring: Når algoritmen bliver tilstrækkelig kompleks er det ikke muligt at forklare, hvad der drev den til at give et bestemt output på grundlag af et bestemt input. Det kalder på varsomhed og er også årsagen til, at AI-forordningen har kvalificeret beslutningsstøttende systemer til “administration of justice” og alternativ konfliktløsning som højrisiko AI-systemer.

De fleste er imidlertid så fokuserede på teknologien, at de glemmer at stille de fundamentale spørgsmål:

(i) Vil vi have robotten til at efterligne/eftergøre en menneskelig juridisk beslutningsproces?

(ii) I bekræftende fald: Hvordan ser den juridiske beslutningsproces ud?

(iii) I benægtende fald: Hvis vi kan leve med at robotten ikke kan/skal efterligne/eftergøre en menneskelig juridisk beslutningsproces – hvilke krav/designkriterier skal i så fald gælde?

(iv) I alle tilfælde: Hvordan skal vi verificere, om robottens output er godt nok?

Disse fire spørgsmål rummer kimen til, at vi som jurister er nødt til at overveje grundlæggelsen af en helt ny disciplin: Juridisk beslutningstagningsteori (eller mere mundret på engelsk: “legal decision making theory“).

Det er ikke fordi retsfilosoffer, psykologer og kognitionsforskere ikke allerede har kredset om beslægtede emner, men reelt set har ingen endnu taget hul på den enorme opgave, som det er at komme svarene på de fire fundamentale spørgsmål nærmere. Og vi er lovlig undskyldt, da det i virkeligheden først er inden for de sidste par år, med fremkomsten af generativ AI, at spørgsmålene er blevet helt nærværende.

Hvad kan “legal decision making theory” bidrage med

Det kommer for vidt i detaljer at gøre rede for, hvad legal decision making theory kan bidrage med. Men overordnet set må den først og fremmest starte med at indkredse modeller til beskrivelse af, hvordan en menneskelig juridisk beslutningsproces rent faktisk kan siges at foregå. Sådanne modeller kan enten være deskriptive eller normative, men de vil være konstruktioner, og der vil i den forbindelse være kognitive elementer vi ikke (eller kun vanskeligt) kan afdække – såkaldte emergente egenskaber.

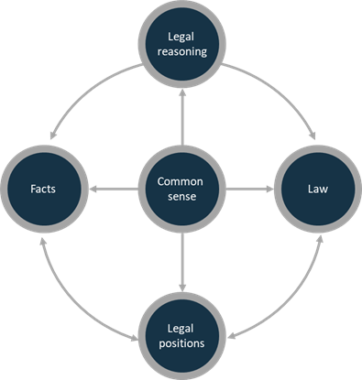

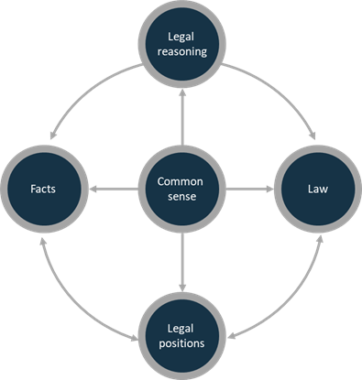

Et eksempel på en sådan beslutningsmodel er den iterative model:

Modellen illustrerer, at beslutningstageren udfører en proces, hvor fakta og jus i en mental cirkelbevægelse former udkast til præmisser, som så igen danner udkast til juridiske positioner – alt under indflydelse af forholdets natur (i modellen angivet som “common sense”). Når beslutningstageren finder, at det hele tvangfrit hænger sammen, udkrystalliserer det sig i en konkret afgørelse med præmisser og konklusion (de juridiske positioner).

Modellens styrke er, at den kan forklare det paradoksale: Hvorfor to voldgiftsdommere kan være uenige og samtidig hver for sig have ret – det kan de hvis de lægger vægt på forskellige aspekter af jus, fakta og/eller forholdets natur (common sense), som så genererer hver sit sæt af præmisser og juridiske positioner.

En mere kynisk tilgang til juridisk beslutningstagning kan være en skepticistisk model, hvor beslutningstageren først beslutter sig definitivt for resultatet og derefter finder den bedst tænkelige begrundelse for det.

Begge modeller kan faktisk anvendes i konteksten af generativ AI.

Den iterative model vil kræve, at beslutningstageren løbende prompter (fodrer) robotten med fakta, jus og common sense betragtninger for til sidst at nå en ligevægtstilstand, hvor beslutningstageren finder at der er taget behørigt hensyn til alle elementer.

På samme måde kan den skepticistiske model anvendes ved at prompte robotten for et svar: “Skriv mig de bedste præmisser for en kendelse, der skal sige resultere i [X]“. Hvis skepticisten ikke er tilfreds kan han/hun prompte med yderligere fakta, jus og common sense, som så danner nye præmisser, men med de på forhånd fastlagte juridiske positioner som fikspunkter.

Legal decision making theory er reelt også en nødvendig disciplin i forhold til AI Forordningen, som kræver “human oversigtht“, hvilket blandt andet indebærer, at “High-risk AI systems shall be designed and developed in such a way, including with appropriate human-machine interface tools, that they can be effectively overseen by natural persons during the period in which the AI system is in use”.

Kan AI i virkeligheden tage os til et nyt niveau?

Et af de sværeste spørgsmål at besvare er, hvordan vi skal verificere, om robottens output er godt nok? Der findes ganske simpelt ikke en facitliste.

Den gode nyhed i den forbindelse er så, at det har vi altid levet med under de menneskelige voldgiftsdommere. Med andre ord vil anvendelse af AI aldrig helt kunne bringe mennesket ud af spil, men det skaber imidlertid nye dilemmaer. Vil voldgiftsdommeren være i stand til at udfordre output, hvis kvaliteten af robotternes arbejde bliver tilstrækkelig god – og på hvilket grundlag skal han/hun gøre det?

Spørgsmålet om “godt nok” giver imidlertid også anledning til at stille et femte spørgsmål – et spørgsmål, som i virkeligheden er det mest revolutionerende:

Kan robotten vise os, at den måde, vi træffer beslutninger på i dag, udstiller “menneskelig svaghed”, og at robotterne faktisk kan træffe bedre beslutninger end dem vi træffer i dag uden brug af AI?

Kognitionsforskningen har igennem de sidste 50-75 år vist os en lang række “mangler” ved den menneskelige beslutningsproces. Mest kendt er Nobelprismodtageren Daniel Kahneman, der i samarbejde med med Amos Tversky har udviklet tankerne om den menneskelige bevidsthed opdelt i et “system 1” og et “system 2”. System 1 er drevet af intuition, fungerer automatisk, hurtigt og kræver mindre eller slet ingen anstrengelse. “System 2” er det reflekterende system, som kræver anstrengelse og anvendes når der er flere valgmuligheder.

Juridisk beslutningstagning og afgørelse af voldgiftssager er åbenlyst “system 2-arbejde”, men Daniel Kahnemans pointe er, at vi ganske enkelt ikke har nok “båndbredde” til udelukkende at fungere med brug af system 2, hvorfor vi ubevidst altid starter med og inddrager System 1.

I den proces opstår der støj og bias – eksempelvis i form af “halo-effekten” (glorie-effekten), hvor mennesket ved erkendelse af et sympatisk træk hos en person ubevidst indfortolker andre positive træk ved den pågældende, selvom der ikke er belæg for det. Optræder en sådan bias eksempelvis ved en juridisk beslutningstagers vurdering af et vidnes troværdighed, vil dette potentielt kunne føre til fejlagtige afgørelser.

Legal decision making theory kan i samspil med kognitionsforskningen være med til undersøge, om anvendelsen af AI kan målrettes og medvirke til at eliminere støj og bias, som i dag reelt fører til forkerte juridiske afgørelser.

Voldgiftsforeningen afholder 13. juni 2024 arrangement om AI, hvor bl.a. Niels Chr. Ellegaard vil holde indlæg om anvendelse af AI inden for voldgift og uddybe tankerne i artiklen yderligere (artiklen baserer sig delvist på de tanker og teorier, der er fremsat i bogen “Robots entering the legal profession” (2019) – Hans Reitzels Forlag.

Niels Chr. Ellegaard

Partner i Plesners Teknologi & Outsourcing team, og er overordnet ansvarlig for rådgivning inden for IT, Telecom, Teknologi og Outsourcing. Igennem sin karriere har Niels beskæftiget sig med et bredt udsnit af juridiske områder og er udover IT, telecom og outsourcing beskæftiget med bestyrelsesarbejde og sager inden for selskabsret. Niels bruger sin brede erfaring til både at udarbejde og forhandle kontrakter og rådgive, hvis der måtte opstå konflikter. Han fungerer også som advokat og voldgiftsdommer i IT-tvister.